LCM: l'evoluzione dell'intelligenza artificiale verso la comprensione concettuale

Questa nuova, affascinante frontiera dell'IA conversazionale è stata descritta da Meta in un paper intitolato Large Concept Models: Language Modeling in a Sentence Representation Space che, presentando i risultati del lavoro sviluppato con SONAR (uno spazio di embedding di frasi in grado di coprire fino a 200 lingue), ha evidenziato i vantaggi derivanti dallo spostamento del focus da modelli predittivi di singoli token a modelli in grado di gestire intere frasi come entità semantiche, da intendere come concetti. Ponendosi come naturale evoluzione dei LLM, i Large Concept Model non si limitano a comprendere e generare linguaggio, ma mirano a catturare, rappresentare e ragionare su concetti complessi in modo più strutturato e semanticamente ricco.

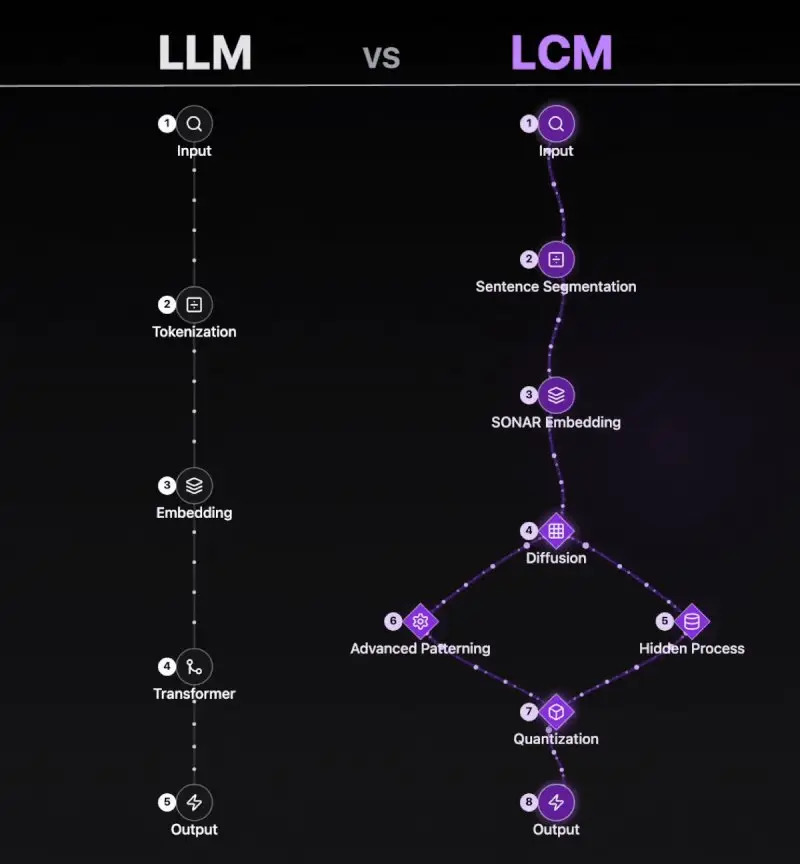

In altre parole, il cambiamento introdotto dai LCM consiste in un approccio innovativo all'elaborazione del linguaggio naturale, che muove dall'analisi dei token a quella dei concetti, rendendo possibile una modalità di ragionamento capace di superare l'approccio predittivo su cui si basano gli attuali modelli di IA generativa. Considerando come unità non più i singoli termini di una frase, ma la frase stessa, questo nuovo modello riesce ad aggredire in modo efficace il problema del contesto, rispetto al quale i Large Language Model mostrano più di un punto debole. In questo senso, incrementando le prestazioni dell'IA in termini di conoscenza contestuale nel trattamento di testi ad alto tasso informativo, i Large Concept Model assicurano risultati migliori sotto il profilo della coerenza, contribuendo a minimizzare in maniera rilevante la dispersione informativa.

In particolare, il rapporto pubblicato da Meta mette in luce il vantaggio decisivo di questi modelli rispetto ai "predecessori" token-based: la possibilità di ricorrere ad una generalizzazione di tipo zero-shot, ovvero senza la necessità di impiegare un addestramento specifico.

- Ragionamento concettuale: questi modelli non si limitano a "predire parole", ma sono in grado di estrarre conoscenza, inferire relazioni di natura causale e prendere decisioni basate su concetti e modelli logici.

- Generalizzazione forte: grazie alla loro struttura concettuale, i LCM sono rapidamente adattabili a compiti e domini nuovi, con un ridotto bisogno di dati specifici e fine-tuning.

- Multimodalità nativa: progettati per elaborare simultaneamente input di tipo diverso (immagini, testi scritti, audio e altri segnali), i LCM denotano una capacità di comprensione più profonda del contesto e una maggiore versatilità nelle applicazioni.

L'emergere dei Large Concept Model delinea importanti prospettive di applicazione in ambito industriale: a differenza dei tradizionali sistemi basati su regole o dei modelli linguistici esclusivamente focalizzati sul testo, i LCM realizzano una comprensione più completa e flessibile del contesto operativo, risultando ideali per applicazioni in ambienti complessi e dinamici.

Alberto Vigolungo