'Perché non parli?'

‘Ok, ci penso io’

La diffusione degli assistenti virtuali ha prodotto una nuova rivoluzione nel rapporto tra l’uomo e la tecnologia. Per ora questa rivoluzione, il ritorno alla scrittura come elemento prevalente rispetto all’immagine, è solamente all’inizio, ma la sua marcia appare ogni giorno di più inarrestabile.

Tale evoluzione è dovuta al fatto che ci aspettiamo sempre di più dalle macchine: non ci accontentiamo più di un atteggiamento reattivo, dove la macchina risponde solo se interpellata, desideriamo un’interazione più articolata, spesso proattiva, che sia molto più di una risposta. Tutto questo si incrocia inevitabilmente con internet: non esiste infatti più alcun aspetto delle nuove tecnologie che non si riferisca a lei in qualche modo; inoltre, Internet ha offerto a tutti l’accesso ad un quantitativo infinito di informazioni, di fronte alle quali le nostre domande si fanno forzatamente più imprecise ed esitanti. Abbiamo bisogno allora di qualcosa che cambi la situazione, che ci aiuti a focalizzare meglio le nostre richieste o che ci sostituisca nella prima scrematura dei risultati.

Nell’ambito degli strumenti di relazione tra uomo e macchina i chatbots si presentano come agenti proattivi che guidano l’utente all’interno del set di informazioni posseduto. Alcuni sono anche in grado di ricercare informazioni in tempo reale, aggiornandosi a seconda delle necessità dell’umano che li sollecita.

Gli assistenti virtuali più evoluti sono quelli sviluppati negli ultimi anni ma, in realtà, quello che abbiamo oggi è il risultato di una evoluzione ormai cinquantennale. Il passaggio fondamentale visto recentemente è stato quello dell’evoluzione di questi strumenti dal mondo puramente conversazionale a quello delle interfacce multimediali che offrono ed usano voce, immagini e bottoni di comando creando un sistema integrato che modifica il significato e la funzione stessa del chatbot, in questi casi rinominato spesso HMI, ovvero Human Machine Interface.

Nuove professioni

La prevalenza della parola sul segno ha diversificato anche l’uso dell’espressione Web Designer che non è più associata esclusivamente al segno grafico ma anche a quello testuale. Da qui, nuove figure professionali come quella del Dialogue Designer, spesso ricoperta da linguisti, giornalisti, copywriters e psicologi, figure umanistiche che sempre più spesso lavorano gomito a gomito con il Data Scientist, di solito un ingegnere, un fisico o matematico il cui compito è studiare e applicare i processi di apprendimento della macchina. Dall’unione delle due competenze nasce ciò che oggi è chiamato Natural Language Processing.

Natural language processing

Il processo che permette alla macchina di comprendere e relazionarsi con gli esseri umani è il Natural Language Processing (NLP) al quale si affianca molto spesso il Machine Learning, la tecnologia che si occupa di darle una capacità di apprendimento.

I primi esperimenti di NLP risalgono agli anni ’50 quando venne definito il Test di Turing, consistente nel far interagire senza contatto visivo o sonoro una persona con un umano ed un bot che si alternavano a sua insaputa. La qualità di quest’ultimo viene da allora misurata nel tempo medio necessario alla persona di iniziare a distinguere con certezza quando si interfaccia con un bot oppure no. Per molto tempo lo scoglio insuperabile è risultato dare uno scopo specifico al bot (come ad esempio accade oggi i servizi di assistenza clienti). La svolta è arrivata recentemente, con la creazione di algoritmi più potenti e di nuovi canali che hanno permesso di “chiudere” i bot con obiettivi definiti, al servizio delle aziende.

Dando uno scopo alla macchina, anche la User Experience ne ha risentito positivamente.

Il bot di oggi

La ricerca sulle Reti Neurali Artificiali è iniziata negli anni ’80, ma l’utilizzo pratico della capacità computazionale applicata all’intelligenza artificiale risale agli anni2000 con la loro applicazione al riconoscimento delle immagini.

L’applicazione al linguaggio, invece, è ancora più recente: la potenza computazionale si evolve di giorno in giorno e permette di gestire quantità sempre più elevate di dati, d’altronde gli algoritmi più performanti sono recentissimi e il settore è così giovane che spesso la “ricerca e sviluppo” si evolve di pari passo con il “business”. Non a caso, se vi dovesse capitare di fare visita alla sede di una società di bot conversazionali, è facile che incontriate qualcuno alle prese con funzioni matematiche e schemi legati al sistema del linguaggio umano.

Word Embedding

Oggi il NLP è concentrato ha esteso il suo raggio di studio oltre la singola parola comprendendo interi blocchi, se non addirittura di intere frasi e paragrafi. Un modus operandi che permette di fronteggiare in modo più efficace i problemi di disambiguazione che spesso si presentano. Infatti, non è raro imbattersi in parole che possono avere più significati: la mappatura delle frasi e delle parole ha reso possibile evitare queste insidie, permettendo di aggiudicare alle parole il senso più coerente con il contesto in cui sono inserite.

La macchina che pesa le parole.

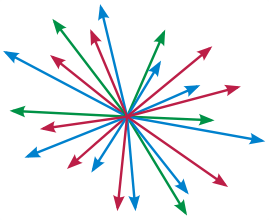

Ma come si fa? Non possiamo negarlo, non è esattamente come immaginarsi una barchetta in mezzo alle onde, ma proviamoci lo stesso. Immaginate uno spazio vettoriale nel quale le parole vengono disposte più o meno lontane le une dalle altre, in base alla loro semantica. Il nome del processo che produce tale spazio è Word Embedding.

Le parole sono descritte ciascuna da un vettore, ordinariamente composto da circa 100 dimensioni: i sinonimi o le parole che in una data lingua sono simili od associate ad essa saranno vettori più vicini. Se il processo viene moltiplicato per più lingue si può iniziare a comprendere come possa essere possibile il processo di traduzione automatica dei testi. Ma tutto ciò è solo l’inizio.

Machine Learning

L’applicazione degli Algoritmi di Machine Learning ha permesso di andare oltre il word embedding, consentendo un’analisi testuale che metta in relazione le singole parole con il contesto in cui si trovano. Tipico esempio di tali algoritmi è BERT, di cui parleremo in un successivo contributo. I risultati dipendono però sia da come viene strutturato il modello, sia dal tipo di dati che vi vengono inseriti. Un modello applicato nel modo sbagliato può portare a conclusioni addirittura opposte rispetto al risultato sperato. Nella realizzazione di applicazioni e prodotti reali legati ai chatbots, il sistema più utilizzato è quello supervisionato. Sia in ambito di ricerca che nelle applicazioni aziendali, si stanno diffondendo anche approcci non supervisionati che in molte applicazioni costituiscono lo stato dell’arte.

Un esempio è stata l’evoluzione che ha subito il tool di traduzione più usato online: Google Translate, al quale, dal novembre 2016, è stato applicato il Deep Learning, ovvero un insieme di reti neurali profonde capaci di dare traduzioni coerenti di periodi complessi. Ciò ha permesso al tool di fare passi in avanti mai raggiunti in nove anni di vita. Tale approccio ha permesso di considerare traduzioni di intere frasi, a differenza di prima, quando le parole venivano analizzate indipendentemente dal contesto.

Enrico Versino